本文最初发表于广达杂志社。

一张图片胜过千言万语,但一个单词又能抵得上多少个数字呢?这个问题可能听起来很傻,但它恰好是大型语言模型(法学硕士)的基础,并且通过它们,人工智能的许多现代应用都是如此。

每个法学硕士都有自己的答案。在meta的开源Llama 3模型中,单词被分成由4096个数字表示的令牌;GPT-3的一个版本是12288。单独来看,这些长长的数字列表——被称为“嵌入”——只是难以理解的数字链。但同时,它们对单词之间的数学关系进行编码,这些关系看起来出奇地像意思。

单词嵌入背后的基本思想已经有几十年的历史了。要在计算机上模拟语言,首先从字典中取出每个单词,并列出它的基本特征——有多少由你决定,只要每个单词都是相同的。“你几乎可以把它想象成一个20问游戏,”在布朗大学和谷歌DeepMind研究语言模型的计算机科学家埃莉·帕夫利克(Ellie Pavlick)说。“动物、蔬菜、物体——这些特征可以是人们认为对区分概念有用的任何东西。”然后为列表中的每个特征分配一个数值。例如,dog这个词在“毛茸茸的”上得分很高,但在“金属的”上得分很低。结果将把每个单词的语义关联及其与其他单词的关系嵌入到一个唯一的数字串中。

研究人员曾经手工指定这些嵌入,但现在它们是自动生成的。例如,神经网络可以被训练成根据网络自己定义的特征对单词(或者,技术上讲,被称为“标记”的文本片段)进行分组。帕夫利克说:“也许有一种特征能很好地区分名词和动词,而另一种特征则能区分在句号后出现的单词和在句号后不出现的单词。”

这些机器学习嵌入的缺点是,与20个问题的游戏不同,每个数字列表中编码的许多描述是人类无法解释的。帕夫利克说:“这似乎是一个大杂烩。”“神经网络可以以任何有用的方式组成特征。”

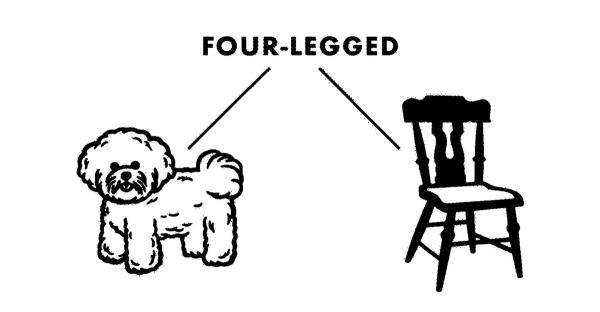

但是,当一个神经网络被训练在一个叫做语言建模的特殊任务上时——这里涉及到预测序列中的下一个单词——它学到的嵌入绝不是任意的。就像铁屑在磁场下排列一样,这些值的设置方式使得具有相似关联的单词在数学上具有相似的嵌入。例如,狗和猫的嵌入将比狗和椅子的嵌入更相似。

这种现象使嵌入看起来很神秘,甚至很神奇:神经网络以某种方式将原始数字转化为语言意义,“就像把稻草纺成金子一样,”帕夫利克说。“文字算术”的著名例子——国王减去男人加上女人大致等于女王——只会增强嵌入的光环。它们似乎是LLM“知道”的丰富而灵活的知识库。

但这些所谓的知识与我们在字典中找到的东西完全不同。相反,它更像是一张地图。如果您将每个嵌入想象为由其他嵌入共享的高维地图上的一组坐标,您将看到某些模式弹出。某些词会聚集在一起,就像郊区拥抱大城市一样。同样,狗和猫的坐标会比狗和椅子更相似。

但与地图上的点不同的是,这些坐标只指向彼此,而不指向任何潜在的领土,就像纬度和经度数字表示地球上的特定地点一样。相反,狗或猫的嵌入更像是星际空间中的坐标:除了它们碰巧离其他已知点有多近之外,没有任何意义。

那么,为什么狗和猫的嵌入如此相似呢?这是因为他们利用了语言学家几十年前就知道的东西:在相似的语境中使用的单词往往具有相似的意思。在“我雇了一个宠物保姆来喂我的____”这个序列中,下一个单词可能是狗或猫,但可能不是椅子。你不需要字典来判断,只需要统计数据。

嵌入——基于这些统计数据的上下文坐标——是LLM如何找到一个好的起点来进行下一个单词的预测,而不依赖于定义。

某些词在特定的语境中比其他词更合适,有时精确到没有其他词可以代替。(想象一下,当你完成“法国现任总统的名字是____”这句话的时候)根据许多语言学家的说法,人类之所以能很好地辨别这种契合感,很大程度上是因为我们不只是把单词和单词联系起来——我们实际上知道它们指的是什么,就像地图上的领土一样。语言模型不会,因为嵌入不是那样工作的。

然而,作为语义的代理,嵌入被证明是非常有效的。这也是大型语言模型迅速上升到人工智能前沿的原因之一。当这些数学对象以一种与我们的期望相吻合的方式组合在一起时,感觉就像智慧;当他们不这样做时,我们称之为“幻觉”。然而,对于法学硕士来说,没有什么不同。它们只是一串数字,在空间里消失了。

为您推荐:

- 实测教程“蜀山四川麻将助赢神器(专用辅牌神器免安装) 2025-07-15

- 终于发现“微信红包埋雷辅助软件,原来是有人用开挂”(详细透视教程)-哔哩哔哩 2025-07-15

- 2分钟秒懂!“蜀山四川麻将亲友房提升70%好牌”(详细辅助教程)-哔哩哔哩 2025-07-15

- 新版本“微信红包避雷发11个包控制尾 数”(详细透视教程)-哔哩哔哩 2025-07-15

- 实测分享“微信微乐麻将挂件神器”(详细透视教程)-哔哩哔哩 2025-07-15

- 终于发现了“微信红包扫雷控制尾数挂”(详细透视教程)-哔哩哔哩 2025-07-15